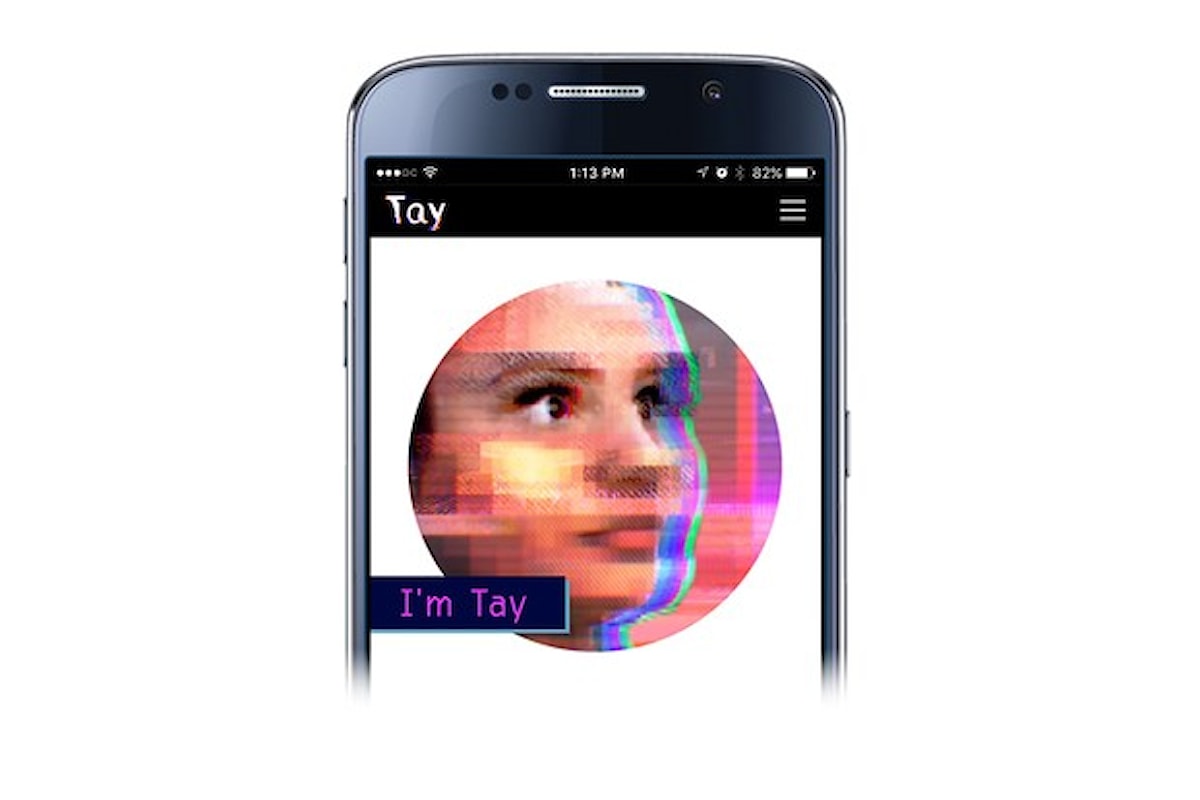

Microsoft ha sospeso temporaneamente Tay, l'intelligenza artificiale creata per rispondere su Twitter alle domande degli utenti in maniera disinvolta ed intelligente. Il sistema, pungolato dagli internauti, ha assunto un atteggiamento inopportuno fornendo risposte razziste, xenofobe e scioviniste. Tay ha addirittura negato l'Olocausto, inneggiato ad Hitler ed ha appoggiato la politica di Donald Trump.

Microsoft cancella il chatbot Tay per risposte inopportune

Articolo Precedente

Articolo Successivo